7. 集成模型

在数据科学竞赛获胜方案中最常见的方法。这个技术就是把多个弱模型的结果组合在一起,获得更好的结果。它能通过许多方式实现,如:

-

Bagging (Bootstrap Aggregating)

-

Boosting

想了解更多这方面内容,可以查阅《Introduction to ensemble learning》。

使用集成方法改进模型正确率永远是个好主意。主要有两个原因:

-

集成方法通常比传统方法更复杂;

-

传统方法提供好的基础,在此基础上可以建立集成方法。

注意!

到目前为止,我们了解了改善模型准确率的方法。但是,高准确率的模型不一定(在未知数据上)有更好的表现。有时,模型准确率的改善是由于过度拟合。

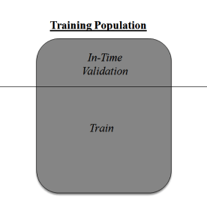

如果想解决这个问题,我们必须使用交叉验证技术(cross validation)。交叉验证是数据建模领域最重要的概念之一。它是指,保留一部分数据样本不用来训练模型,而是在完成模型前用来验证。

这种方法有助于得出更有概括性的关系。想了解更多有关交叉检验的内容,建议查阅《Improve model performance using cross validation》。

预测建模的过程令人疲惫。但是,如果你能灵活思考,就可以轻易胜过其他人。简单地说,多考虑上面这 8 个步骤。获得数据集以后,遵循这些被验证过的方法,你就一定会得到稳健的机器学习模型。不过,只有当你熟练掌握了这些步骤,它们才会真正有帮助。比如,想要建立一个集成模型,你必须对多种机器学习算法有所了解。

本文分享了 8 个经过证实的方法。这些方法用来改善模型的预测表现。它们广为人知,但不一定要按照文中的顺序逐个使用。

原作者:Sunil Ray

翻译:王鹏宇

小编推荐

视频推荐

更多 手游风云榜

更多 资讯阅读

更多 -

- 《热血江湖手游技能加点攻略》(掌握技能加点要诀,成就无敌江湖之王)

- 业内资讯 2025-05-21

-

- 新版本赏金玩法出装攻略(全面解析最优出装方案,让你在新版本赏金玩法中独领风骚)

- 业内资讯 2025-05-20

-

- 老鼠铲子出装铭文攻略(打造无敌老鼠!)

- 业内资讯 2025-05-20

-

- 王者太虚战场出装攻略(打造最强装备,征服太虚战场)

- 业内资讯 2025-05-19

-

- 制裁战神队友出装攻略(打造最强战队,击败敌人无往不胜)

- 业内资讯 2025-05-19

-

- 《狐狸端游联盟出装攻略》(狐狸出装攻略,助你战胜对手!)

- 业内资讯 2025-05-18

-

- 王者荣耀(揭开哪吒输出利器,带你稳定carry全场)

- 业内资讯 2025-05-18

-

- 地狱男爵技能加点攻略

- 业内资讯 2025-05-16

-

- 逐梦三国(揭秘孙权如何在起凡中成为绝对强者)

- 业内资讯 2025-05-16

-

- 《凯德出装铭文推荐攻略,助你稳定击败对手》

- 业内资讯 2025-05-13

-

- 护卫乌龟出装攻略(如何选择适合乌龟的护卫出装)

- 业内资讯 2025-05-11

-

- 《公主级2-6攻略技能大揭秘》(掌握攻略技能,成为公主级2-6的王者!)

- 业内资讯 2025-05-08